A-A+

从零学习Hadoop之文件在HDFS中的读取和写入

在《从零学习Hadoop之Hadoop的RPC机制》中介绍了Hadoop的RPC机制,本文接着讲述文件是如何在HDFS中进行读取和写入的,注意其中使用到RPC的地方。

文件的读取

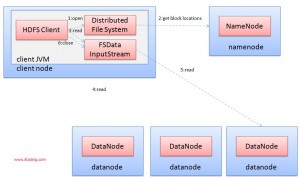

客户端以及与之交互的HDFS、NameNode、DataNode的读取数据流如下图所示:

文件读取的过程如下:

- 使用HDFS提供的客户端开发库Client,向远程的NameNode发起RPC请求。

- NameNode会视情况返回文件的部分或者全部Block列表,对于每个Block,NameNode都会返回该Block副本的DataNode地址。

- 客户端开发库Client会选取客户端最接近的DataNode来读取Block;如果客户端本身就是DataNode,将从本地直接读取数据,就近原则。

- 读取完当前Block的数据后,关闭当前的DataNode连接,并为读取下一个Block寻找最佳的DataNode。

- 当读完列表的Block后,且文件读取还没有结束,客户端开发库会继续向NameNode获取下一批Block列表。

- 读取完一个Block都会进行Checksum验证,如果读取DataNode时出现错误,客户端会通知NameNode,然后从下一个拥有该Block复制的DataNode继续读。

文件的写入

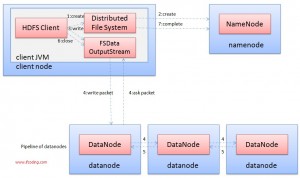

客户端以及与之交互的HDFS、NameNode、DataNode的写数据流如图所示:

写入文件的过程比读取复杂,步骤如下:

- 使用HDFS提供的客户端开发库Client,向远程的NameNode发起RPC请求。

- NameNode会检查要创建的文件是否已经存在,创建者是否有权限进行操作,成功会文件创建一个记录,否者会让客户端抛出异常。

- 当客户端开始写入文件的时候,开发库会将文件切分成多个packet,并在内部以数据队列(data queue)的形式管理这些packet,并向NameNode申请新的Block,获取用来存储replicas的合适的DataNode列表,列表的大小根据在NameNode中对replication的设置而定。

- 开始以管道(pipeline)的形式将packet写入所有的replicas中。开发库把packet以流的方式写入第一个DataNode,该DataNode把packet存储之后,再将其传递给在此管道中的写一个DataNode,直到最后一个DataNode,这种写数据的方式呈流水线的形式。

- 最后一个DataNode成功存储之后会返回一个ask packet,在管道里传递至客户端,在客户端的开发库中维护着ask queue,成功收到DataNode返回的ask packet后会从ask queue移除相应的packet。

- 如果传输过程中有某个DataNode出现了故障,当前的管道会被关闭,出现故障的DataNode会从当前管道中移除,剩余的Block会继续剩下的DataNode中继续以管道的形式传输,同时NameNode会分配一个新的DataNode,保持replicas设定的数量。

文件的一致模型

HDFS应用需要一个“一次写入,多次读取”的文件访问模型。一个文件经过创建、写入和关闭之后就不需要改变。这一假设简化了数据一致性问题,并且使高吞吐量的数据访问成为可能。MapReduce应用或者网络爬虫应用都非常适合这个模型。

关于文件在HDFS中的读写先介绍这些。

参考资料

书名:Hadoop应用开发技术详解

作者:刘刚